Надо “ладить” с этим роботом, если вы владелец сайта:) Как владелец сайта может использовать robots.txt? Добрый день, дорогие друзья! Вы на страницах моего блога INFOZET.RU! Давайте начнём разбирать вопрос об использовании robots.txt.

Для успешной работы сайта требуется две вещи. Первое – усидчивость его владельца на раннем этапе развития. И второе – стабильная работа ресурса на всём протяжении жизни сайта. И для ключевой точки этой задачи нам потребуется ответить на вопрос – как владелец сайта может использовать файл robots.txt.

- Что такое файл robots.txt

- Как владелец сайта может использовать файл robots.txt

- robots.txt для WordPress

- Что представляет собой файл Robots txt

- Владелец сайта может использовать robots.txt

- Как владелец сайта может использовать робот TXT – наглядно

- Какие символы в robots.txt используются

- Лучший файл robots.txt

- Как нельзя заполнять файл robots.txt

- Как владелец сайта может использовать robots.txt — важные моменты

- Валидация robots.txt

- Стандарт исключений для роботов

- И не много истории..

- Заключение

Что такое файл robots.txt

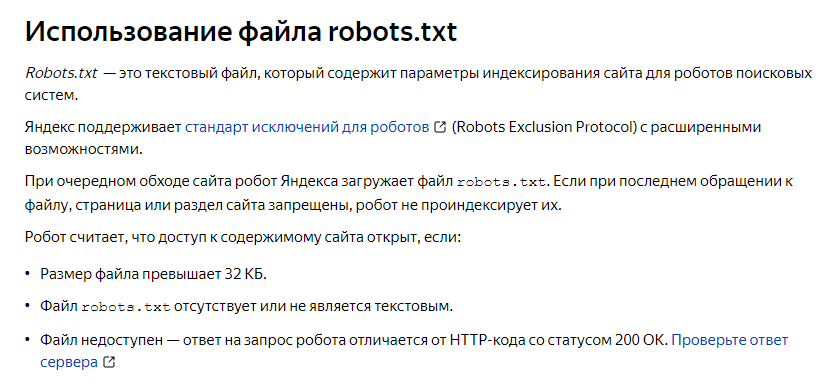

Это текстовый файл который содержит все параметры индексирования вашего сайта. Он нужен для роботов поисковых систем

По другому это – стандарт исключений для роботов.

Базовая информация указана здесь, в Яндекс Вебмастер. И там же можно проверить в каком состоянии по отношению к этому документу находится ваш сайт.

Как владелец сайта может использовать файл robots.txt

Этот документ можно использовать не только для правильной индексации вашего веб-ресурса, но и просто упорядочить его.

Это очень сильно влияет на WordPress. Те веб мастеры, у которых стоит CMS Вордпресс будет особенно полезно знать как использовать файл robots.txt. У которых стоит другой движок (другая система), для них так же полезно будет это знать, так как у всех схожие адаптационные моменты. Но, для WordPress это будет особенно полезно.

robots.txt для WordPress

На движке Вордпресса уже изначально создан виртуальный файл robots.txt. Поэтому его вставлять, дополнять, убирать – совсем не обязательно. Однако, многие хотят видоизменить содержимое робота, полагая на то, что это скажется на индексации. Эта теория относительно не верна.

Например: если вы думаете что изменив, уже автоматически созданный robots.txt в Вордпресс – вам поможет это с индексацией. Примерно, начинающие веб-мастера рассчитывают на 10-20 а то и 30% улучшения позиций, поковырявшись в этом роботе. Спешу вас огорчить, хотя, может наоборот обрадовать. Данный факт будет мало зависеть от ваших прямых воздействий на него, более того, если что-то сделать не правильно, можно сильно ухудшить свои позиции в поисковой выдаче. Но, если вы всё-таки решились этим заняться, и, так случиться что вы всё сделаете верно, то улучшений в процентном соотношении можно ожидать порядка 1-2 или может быть 3%. Не густо и вообще почему так? Да всё просто.

Люди начали искать проблему не так где нужно, и вместо того чтобы писать много хороших статей, пытаются повлиять на индексацию своего сайта путём решения технических моментов. Понятно почему так происходит? Люди внушили себе что «сейчас всё поправлю как надо, и делать ничего не нужно будет, всё пойдёт как по маслу». И соответственно многие из них, через какое-то время сильно разочаровываются и вообще бросают свой сайт. Так что, этот момент он больше связан с психологией людей, нежели с техническими моментами.

Что представляет собой файл Robots txt

Какие есть критерии файлов? Это самый стандартный текстовый документ и сохранённый с применением кодировки UTF-8. Это создано для работы с протоколами:

- HTTPS

- HTTP

- FTP

Важно понимать, что файл должен сохранятся именно в кодировке UTF-8. Если это будет сделано иначе, то поисковая система может понять протокол по своему, и вообще сделать всё с точностью да наоборот.

Владелец сайта может использовать robots.txt

Файл Robots.txt является важной частью любого сайта – будь то информационного или коммерческого типа. Это важно – создавать некие правила и алгоритмы самой поисковой системе. Всё в конечном итоге сказывается на его продвижении в рейтинге и позициях. Вот такой вот он роботс ти экс ти.

По другому его называют индексный файл.

Нужно знать – владелец сайта может использовать его в ограниченных количествах – так как Google установил ограничение по размеру файла.

Robots.TXT должен весить не более 500 кб.

Как владелец сайта может использовать робот TXT – наглядно

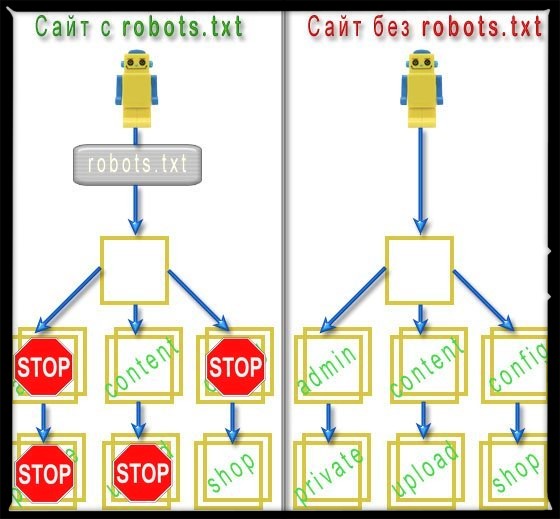

Не все сразу понимают значение робота.

Для наглядности примера возьмём вот этот рисунок, который даёт возможность понять визуально и более прижимисто.

Что мы здесь видим? С правой стороны от вас это тот вариант развития индексации – если бы у вас отсутствовал robots.txt. А слева он присутствует – и мы наблюдаем вроде некоего фильтра, для поисковых роботов.

К примеру – если вы скажете себе, мол зачем его вообще ставить и скрывать мне нечего – пусть всё индексируют, вы можете прогадать. Если поисковики будут индексировать всё подряд – они будут это делать долго и самое главное – они могут вообще не добраться до некоторых ваших материалов на сайте. Каждому роботу из поисковых систем дана алгоритмическая задача, и на её решение отведено определённое количество времени. Он может успеть проиндексировать то что вам не нужно, а то что нужно – не успеет. Поэтому это так важно с точки зрения оптимизации и скорости сайта.

Какие символы в robots.txt используются

Давайте рассмотрим следующее, какие символы можно использовать в robots.txt, и так же поймём их значение.

Основные символы robots.txt:

- «/» – этот символ нам понадобиться если мы захотим закрыть что-то от сканирования поисковиками. Несколько примеров: /sait/ – если мы так же расставим символы до и после, то папка будет полностью закрыта и не будет сканироваться поисковиками. /sait – если вы введете такую команду, то на вашем сайте будут уже закрыты все ссылки которые будут начинаться так же – /sait.

- «*» – этот символ ставится на каждую последовательность ваших символов в файле и будет устанавливаться в конце правила. Пример: /sait/ *. И значит это что поисковым роботам запрещено сканирование данного файла и индексирование в каждой папке где будет встречаться данная запись.

- «$» – данный символ означает ограниченное действие знака *. Как раз его мы сможем использовать, чтобы данное ограничение распространялось только на то, что нужно конкретно нам. Приведём пример: /sait/ *. fantom $. Это не даст роботам индексировать папки и файлы содержащие данный символ, но даст к примеру проиндексировать URL данного файла.

- «#» – этот вид знака отведён для комментариев и заметок. Вебмастер может формировать и структурировать для себя лично отдельные комментарии которые так же не будут видны поисковым роботам, и не будут поддаваться индексированию.

Лучший файл robots.txt

Для того чтобы определить для себя, какой будет идеальный файл robots.txt нужно: понять что вам необходимо скрыть, и сделать это максимально выгодно для ранжирования, чтобы не потерять потенциальных пользователей.

Многое будет зависеть от тог, какой движок и систему вы используете для работы с сайтом. Это нужно чётко понимать и следовать всем подсказкам и инструкциям. Существуют правила и основные знаки которые ни в коем случае нельзя видоизменять или пытаться подстроить по себя.

Как нельзя заполнять файл robots.txt

Рекомендации для всех вебмастеров, не важно какие системы управления вы используете:

- Нельзя видоизменять и допускать банальные ошибки в названии файла. Некоторые используют следующее: Robots.txt или ROBOTS.TXT, или же пропуская букву robot.txt. Данных примеров может быть множество. Но тут не может быть место для самовыражение. Это чисто технический момент, который нужно один раз правильно настроить. Писать нужно именно robots.txt

- Нужно исполнить правило User-agent. Задайте правило для поисковых роботов, чтобы те считывали конкретную информацию с вашего сайта.

- Никаких лишних знаков быть не должно. Если у вас есть желание пописать лишнего, то лучше написать новую хорошую статью для сайта.

- robots.txt не должен присутствовать там, где поисковые роботы должны искать информацию для индексации контента.

Эти правила вы должны знать. Стоит всегда помнить как НЕ нужно делать.

Как владелец сайта может использовать robots.txt — важные моменты

Для полного понимая картины нужно сказать ещё о некоторых вещах.

Многие советуют использовать атрибут allow. Хотя это значение для вас может не иметь никакого смыла. Ведь поисковые роботы заранее сканируют весь контент на вашем сайте. Выполняя действие с атрибутом allow вы рискуете закрыть что-то важное от поисковой системы. Следовательно – от этого действия лучше воздержаться.

Так же, всегда проверяйте корректность использования robots.txt в рабочей панели Google для вебмастеров. И рабочая панель Yandex не исключение. Эти две поисковые системы наиболее важные – для привлечения тёплого трафика.

Валидация robots.txt

Для полной валидации robots.txt есть множество инструментов. Но самым лучшим подтверждением директивы будет – обращение к первоисточнику. Это опять вам напоминание о Google Search Console. Нужно обязательно проверить всё по второму разу перед запуском и исполнением его действий.

Стандарт исключений для роботов

Стандартом исключений для поисковых роботов является ограничением доступа в корне сайта. Имейте ввиду, что действие файла robots.txt не будет распространяться на те сайты, которые расположены у вас на поддоменах.

И не много истории..

Так когда был создан стандарт robots.txt?

Стандарт robots.txt появился и был принят 30 января 1994 года консорциумом W3C. Поисковые машины сразу ввели это правило, и начали активно его использовать. Среди прочих поисковых систем, его начали использовать вебмастера для своих сайтов.

Его можно было сразу использовать для частичного или полного обхода сайта поисковыми системами.

Через два года в 1996-ом, был сформирован и предложен расширенный стандарт robots.txt. Он включал в себя директивы Visit-time и Request-rate.

Так же вам может быть интересна данная статья: Как правильно составить title.

Заключение

На это будем заканчивать. Вопрос, Как владелец сайта может использовать robots.txt я думаю у вас прояснился, и вы стали более квалифицированным в данном моменте. Вы читали нас, блог INFOZET.RU. Всего вам доброго! Ставьте лайк, пишите комментарии, и читайте следующие статьи. Удачи!

Рассмешила первая картинка:)) автору респект!!

Карабас, это да, помимо этого, вы так же найдёте много полезной информации на тему robots.txt и для чего он может потребоваться.

Спасибо большое! Я только ещё разбираюсь во всём этом.